あらゆる文書を、より速く・より賢く解析

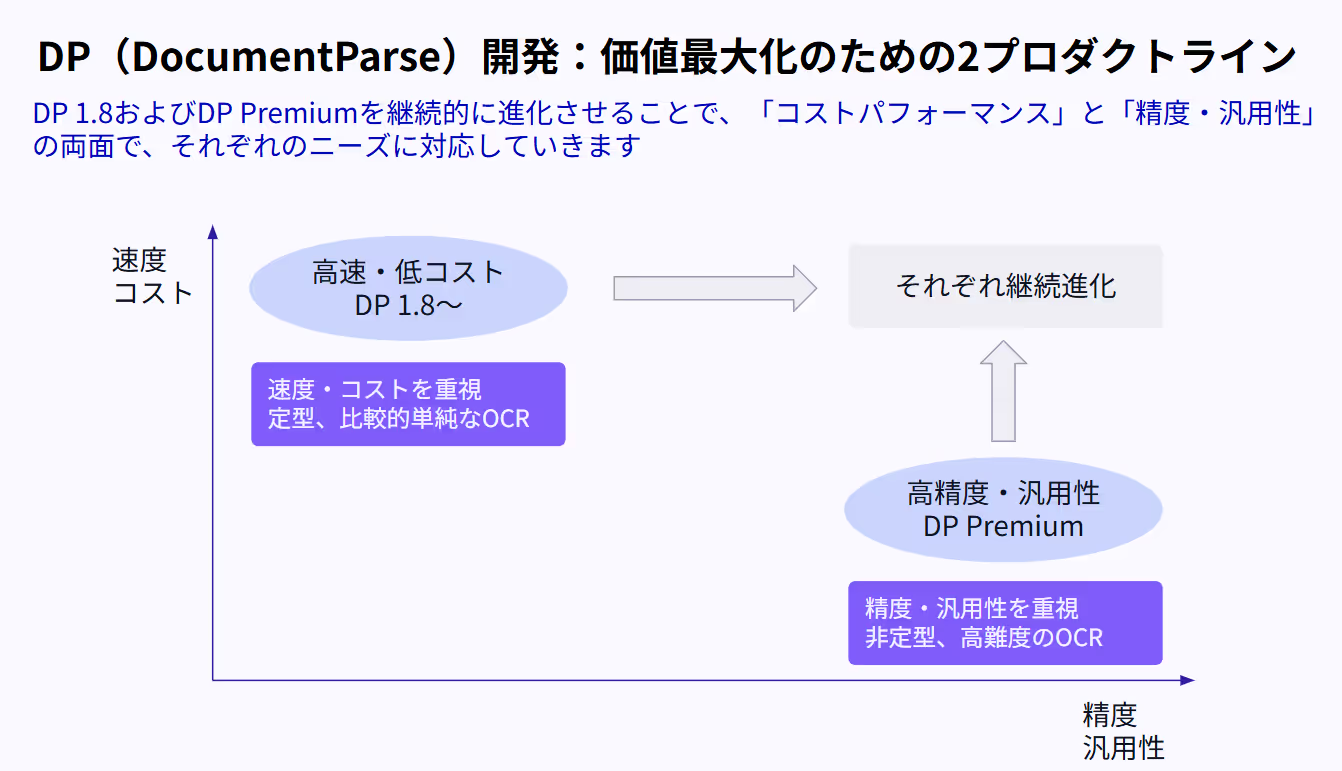

― Upstage Document AI 開発ロードマップ:顧客価値最大化のための2プロダクトライン ―

企業が日々取り扱う請求書、契約書、保険証券、明細書、申請フォームなどの文書は、形式も内容も多岐にわたります。これらを正確に読み取り、データ化することは業務効率を左右する重要な要素です。

一方で、現場の要件は多様です。

「スピードとコストを重視したい現場」もあれば、

「精度と汎用性を優先したい現場」もあります。

Upstageは、こうした異なるニーズに応えるため、これまでグローバル市場のリーディング企業へ導入実績が豊富なDocument AI プロジェクト群を

「Document Parse (機械学習ベース) 」および「Document Parse Enhanced Mode (VLMベース)」の2つのラインで進化させています。

高速・低コストのDocument Parse 1.8シリーズ

Document Parseは、機械学習ベースの技術で特定のビジネス文書の高い読取性能を維持しつつ、「スピード」と「コスト効率」を最優先に設計されたモデルです。事前学習なしでも、多様な日本語フォーマットから安定かつ迅速にデータを抽出することができます。

- 特徴:軽量・高速・コストパフォーマンスに優れたOCR

- 主な用途:請求書、領収書、検収票などの定型文書

面倒な設定や事前テンプレートの登録は不要。そのまま業務システムに組み込むことで、直ちに生産性を向上させることが可能です。

高精度・高汎用のDocument Parse Enhanced Mode

Document Parse Enhanced Modeは、非定型・高難度な文書に特化した上位モデルです。

文脈理解を伴う高精度な情報抽出により、複雑な契約書や保険関連書類にも対応します。

- 特徴:LLMを活用した文脈理解型OCR

- 主な用途:契約書、医療明細、保険約款、審査書類など

単なる文字認識にとどまらず、文書全体の意図や構造を理解した上で情報を抽出します。これにより、複雑な業務プロセスにおいても自動化の範囲を大幅に拡大することが可能です。

なぜ「2ライン」なのか

企業の文書処理ニーズは、一つのアプローチでは解決できません。

そのため、Upstageでは「速度・コスト軸」と「精度・汎用性軸」の2軸で製品を進化させることで、あらゆる業界・業務に最適なソリューションを提供します。

Document Parse(機械学習ベース):

- 高速・低コスト

- 請求書・検収票などの大量処理業務

Document Parse Enhanced Mode(VLMベース):

- 高精度・高汎用

- 保険・金融・公共・医療分野の非定型文書

これら2つのラインは代替ではなく、相互に進化を促し合う「共進化」の関係にあります。Upstage では、両方のモデル開発を自社で行っており、現在では日本語特有のレイアウト等にも対応できるよう、日本チームが中心になりながら、毎月の製品アップデートを実施しております。米国MITポスドク経験のあるリサーチャーに加え、保険業界や各主要産業など、日本の企業環境を熟知するプロフェッショナル人材が多数在籍しており、お客様個々のニーズに合わせた最適な選択肢を提示できることが当社の強みです。

また、最終的にはDocument Parse Enhanced Modeで得た高精度OCR技術を機械学習ベースのDocument Parse へフィードバックし、より軽量かつ高精度なハイブリッドモデルへの進化も視野に入れています。

なぜLLMだけでは足りないのか

大規模言語モデル(LLM)は柔軟な理解力を持ちますが、企業現場の文書処理には「速度」「安定性」「再現性」という別の要素が不可欠です。Document Parseシリーズでは、LLMの知識能力とOCRエンジンの高速処理を統合し、現実のビジネス要件に最適化された設計を実現しています。

クラウド・API・オンプレミスすべてに対応

Document Parseシリーズは、セキュリティや業務要件に応じて柔軟に導入が可能です。

- クラウド:スケーラブルな処理環境で即利用可能

- API連携:ERP、CRM、RPAツールなどに簡単に統合可能

- オンプレミス:データを外部に出さず、閉域環境での運用に対応

まとめ

「コストパフォーマンスの最大化」と「精度・汎用性の追求」。

この両立は、企業の文書処理における長年の課題でした。

Upstage Document Parseは、その両方を実現するために進化を続けています。高速・低コストなDocument Parse、そして高精度・高汎用なDocument Parse Enhanced Mode。

2つのラインが、企業の文書業務を次のステージへと導きます。

.png)

.png)